Chỉ trong tuần này, mô hình DeepSeek R1 đã làm rung chuyển thị trường chứng khoán Hoa Kỳ và thậm chí “vượt mặt” OpenAI ngay trên sân nhà của họ. Sự ra mắt của nó đã xóa sổ 1 nghìn tỷ USD giá trị vốn hóa trên toàn thị trường chứng khoán, trong đó riêng Nvidia đã mất tới 600 tỷ USD. Mặc dù một số công ty đã phục hồi và đang trên đà lấy lại vị thế, rõ ràng DeepSeek đã tạo ra một tác động cực lớn đến các tập đoàn công nghệ điện toán và AI hàng đầu thế giới.

Với những tuyên bố gần như khó tin về chi phí đào tạo mô hình chỉ bằng một phần nhỏ so với OpenAI, đồng thời bán quyền truy cập API với mức giá cạnh tranh đáng kể, câu hỏi đặt ra là DeepSeek đã làm điều đó như thế nào? Chuyện gì đã xảy ra? Có rất nhiều điều cần phân tích ở đây, đặc biệt là xung quanh các tuyên bố của DeepSeek, phản ứng của đối thủ, và cách mà DeepSeek R1 được gọi là “mã nguồn mở” lại không phản ánh toàn bộ bức tranh. Bài viết này của congnghetonghop.com sẽ đi sâu vào những khía cạnh này, giúp độc giả Việt hiểu rõ hơn về công nghệ DeepSeek đột phá và tác động sâu rộng của nó.

DeepSeek R1 và DeepSeek V3: Những Mô Hình AI “Anh Em” Khác Biệt

Sự ra đời và vai trò

Trước hết, DeepSeek đã phát hành hai mô hình chính: V3 và R1. Cả hai đều đóng vai trò quan trọng trong câu chuyện này, nhưng mọi sự chú ý đang đổ dồn vào R1. DeepSeek R1 là mô hình suy luận (reasoning model) của công ty, có khả năng tự đặt câu hỏi và “tự đối thoại” trước khi đưa ra câu trả lời cho một lời nhắc, tương tự như mô hình o1 của OpenAI. Khả năng này giúp DeepSeek R1 xử lý các vấn đề phức tạp một cách sâu sắc và logic hơn.

DeepSeek V3, mặt khác, là một mô hình ngôn ngữ lớn (LLM) đa năng dựa trên kiến trúc Mixture of Experts (MoE) với 671 tỷ tham số. Mô hình này được thiết kế để thực hiện nhiều nhiệm vụ tổng quát, từ tạo văn bản đến dịch thuật.

Cấu trúc và phiên bản

DeepSeek R1 được xây dựng dựa trên DeepSeek-V3-Base. Các phiên bản mô hình R1 nhỏ hơn, với các tham số 1.5B, 7B, 8B, 14B, 32B và 70B, được “chưng cất” từ DeepSeek R1 gốc và dựa trên các mô hình Qwen và Llama. Ngoài ra, DeepSeek R1 cũng có phiên bản 671 tỷ tham số đầy đủ có sẵn để tải xuống. Mặc dù R1 và V3 là những mô hình tương tự nhau, khả năng suy luận vượt trội của DeepSeek R1 chính là yếu tố khiến nó trở nên đặc biệt ấn tượng và thu hút sự chú ý.

Cách thức hoạt động và truy cập

Cách tốt nhất để sử dụng các mô hình DeepSeek R1 và V3 671B là truy cập trang web của DeepSeek, tạo tài khoản và sử dụng như bạn vẫn dùng ChatGPT. Tuy nhiên, do máy chủ của công ty đặt tại Trung Quốc, một số lời nhắc có thể nhận được phản hồi đã qua kiểm duyệt. DeepSeek R1 671B cũng có thể chạy cục bộ, nhưng yêu cầu ít nhất 800 GB bộ nhớ HBM ở định dạng FP8 để hoạt động, theo thông tin từ AWS. Đây cũng là lúc tính chất “open weight” của mô hình phát huy tác dụng, khi bạn có thể tinh chỉnh các tham số để loại bỏ kiểm duyệt, và thực tế đã có một số mô hình không kiểm duyệt được tạo ra thông qua quy trình “abliteration”.

DeepSeek R1 đang chạy cục bộ

DeepSeek R1 đang chạy cục bộ

Quy trình “chưng cất” (distillation) được đề cập khi nói về các mô hình tham số nhỏ hơn có thể không quen thuộc với nhiều người. “Chưng cất” đề cập đến việc sử dụng một mô hình lớn hơn để đào tạo một mô hình nhỏ hơn, trong đó mô hình lớn là “cha mẹ” và mô hình nhỏ là “con cái”. Mô hình con sẽ đặt ra hàng loạt câu hỏi cho mô hình cha mẹ, gắn nhãn các câu trả lời và học hỏi từ các phản hồi đó. Nói cách khác, các mô hình DeepSeek R1 mà bạn có thể chạy cục bộ, dựa trên Qwen và Llama, đã học hỏi từ mô hình DeepSeek R1 lớn hơn.

DeepSeek R1 Có “Đánh Cắp” Từ OpenAI? Cuộc Chiến “Bản Quyền Dữ Liệu” Trong AI

Bối cảnh tranh chấp của OpenAI

OpenAI hiện đang phải đối mặt với một số vụ kiện liên quan đến việc thu thập dữ liệu mà họ đã sử dụng để đào tạo các mô hình của mình. Tờ The Times đã kiện OpenAI, cùng với các hãng tin Canada, Intercept Media và ANI ở Ấn Độ. Vô số vụ kiện khác cũng đang diễn ra, và tất cả đều cáo buộc cùng một điều: OpenAI đã sử dụng dữ liệu của họ mà không được phép để đào tạo các mô hình GPT. Điều này đặt ra một tiền lệ đáng lo ngại về quyền sở hữu trí tuệ trong kỷ nguyên AI.

Các cuộc điều tra và cáo buộc từ Bloomberg/Financial Times

Hiện tại, chưa có ai từ OpenAI chính thức đưa ra tuyên bố rằng DeepSeek đã đánh cắp từ họ thông qua kênh chính thức. Tuy nhiên, cả Bloomberg và Financial Times đều đưa tin rằng OpenAI và Microsoft hiện đang điều tra khả năng này. Trước hết, điều này thực sự là một vấn đề đáng bàn. Ngay cả khi DeepSeek có “đánh cắp” từ OpenAI, thật khó để cảm thông cho một công ty cảm thấy dữ liệu của mình bị lấy đi một cách “trái phép” trong khi những phần đáng kể dữ liệu của chính họ cũng được thu thập theo cùng một cách.

Trên thực tế, OpenAI đã tranh luận ủng hộ những gì họ cáo buộc DeepSeek đã làm. “Đào tạo các mô hình AI bằng cách sử dụng các tài liệu internet có sẵn công khai là sử dụng hợp lý (fair use), được hỗ trợ bởi các tiền lệ lâu đời và được chấp nhận rộng rãi. Chúng tôi xem nguyên tắc này là công bằng với người tạo, cần thiết cho các nhà đổi mới và quan trọng cho khả năng cạnh tranh của Hoa Kỳ,” OpenAI đã từng tuyên bố trong một bài đăng trên blog.

ChatGPT giải thích cách tập luyện cụ thể

ChatGPT giải thích cách tập luyện cụ thể

Bằng chứng phản bác cáo buộc “chưng cất” của DeepSeek

Tuy nhiên, không rõ DeepSeek có thể đã đào tạo dựa trên dữ liệu gì của OpenAI. Mô hình suy luận o1 của OpenAI bị che giấu; khi bạn hỏi o1 một câu hỏi, nó không đưa ra toàn bộ chuỗi suy nghĩ (chain-of-thought) như R1. Đó là một bản tóm tắt, và OpenAI cố tình che giấu cách thức hoạt động bên trong, thậm chí còn khẳng định rất rõ rằng bất kỳ nỗ lực nào nhằm lấy thông tin này sẽ dẫn đến việc tài khoản của bạn bị cấm.

Câu chuyện không dừng lại ở đó. David Sacks, một nhà đầu tư mạo hiểm và “trưởng khoa AI và tiền điện tử” của Nhà Trắng, đã tuyên bố có “bằng chứng đáng kể” về việc chưng cất R1 từ OpenAI. “Có một kỹ thuật trong AI được gọi là chưng cất, mà bạn sẽ nghe nói rất nhiều, và đó là khi một mô hình học hỏi từ một mô hình khác, điều hiệu quả xảy ra là mô hình học sinh hỏi mô hình cha mẹ rất nhiều câu hỏi, giống như một con người sẽ học, nhưng AI có thể làm điều này bằng cách hỏi hàng triệu câu hỏi, và chúng có thể bắt chước quá trình suy luận mà chúng học được từ mô hình cha mẹ và chúng có thể hút kiến thức của mô hình cha mẹ,” Sacks nói với Fox News. “Có bằng chứng đáng kể rằng những gì DeepSeek đã làm ở đây là họ đã chưng cất kiến thức từ các mô hình của OpenAI và tôi không nghĩ OpenAI rất hài lòng về điều này.”

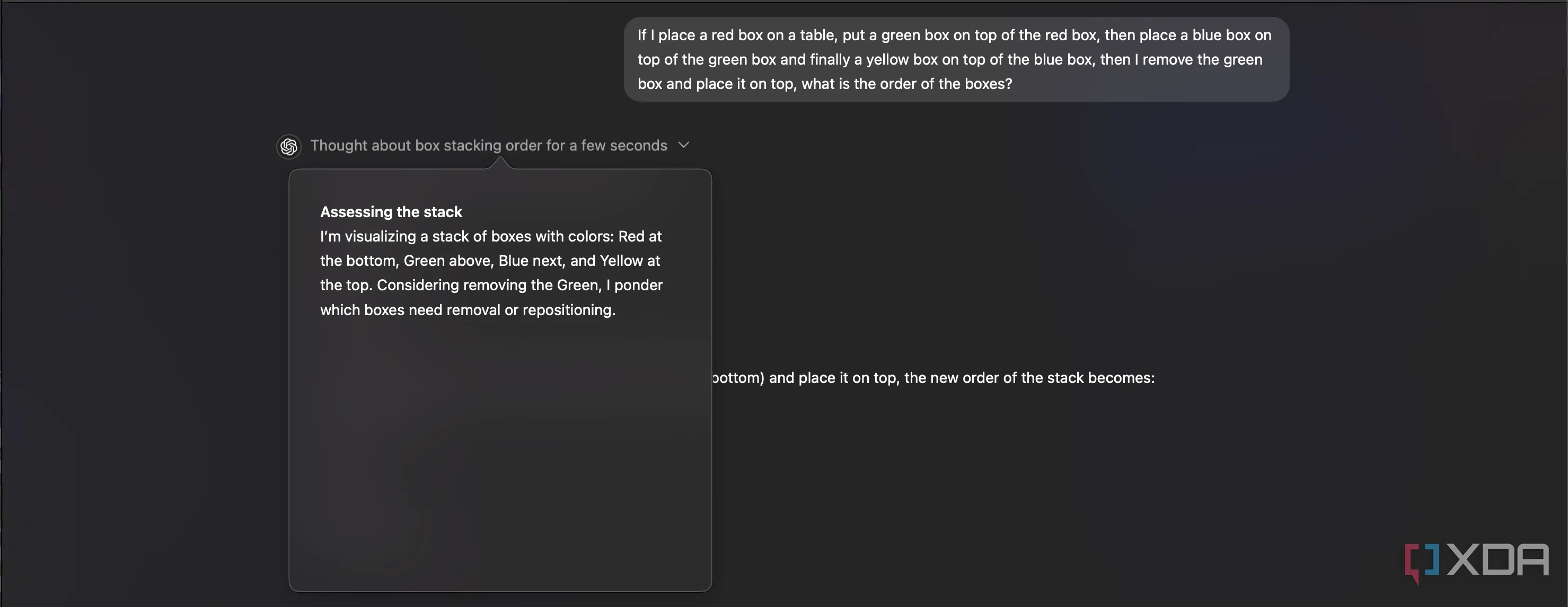

Mô hình suy luận o1 của ChatGPT

Mô hình suy luận o1 của ChatGPT

Như chúng ta đã đề cập, quá trình suy luận này không thể được chưng cất. Chuỗi suy nghĩ bị che giấu mà mô hình o1 hiển thị cho người dùng không chứa toàn bộ chuỗi suy nghĩ, mà thay vào đó tóm tắt những gì nó đang “suy nghĩ”. Điều này không đủ thông tin để đào tạo DeepSeek R1, đặc biệt là khi R1 thực sự sánh ngang (và thậm chí đôi khi vượt trội) nguồn được cho là của quá trình suy luận của nó trong nhiều bài kiểm tra chuẩn.

Nguồn gốc khả năng suy luận của DeepSeek R1

Với những điều đã nói, chúng ta không biết dữ liệu đào tạo ban đầu đến từ đâu, nhưng đó không thực sự là điều mà các cáo buộc về dữ liệu bị đánh cắp liên quan. DeepSeek thực sự đã rất cởi mở về cách khả năng suy luận của R1 ra đời, và trong whitepaper được nhóm các nhà nghiên cứu công bố, họ cho biết các khả năng này xuất hiện thông qua học tăng cường (reinforcement learning) khi xây dựng R1-Zero. Điều này tập trung vào “tự tiến hóa” (self-evolution), một kỹ thuật mà bản thân mô hình “học” cách đạt được mục tiêu một cách hiệu quả nhất.

“Một hiện tượng đặc biệt thú vị được quan sát trong quá trình đào tạo DeepSeek-

R1-Zero là sự xuất hiện của một ‘khoảnh khắc AHA!’. Khoảnh khắc này, như minh họa trong Bảng 3, xảy ra trong một phiên bản trung gian của mô hình. Trong giai đoạn này, DeepSeek-R1-Zero học cách phân bổ nhiều thời gian suy nghĩ hơn cho một vấn đề bằng cách đánh giá lại cách tiếp cận ban đầu của nó. Hành vi này không chỉ là minh chứng cho khả năng suy luận ngày càng tăng của mô hình mà còn là một ví dụ hấp dẫn về cách học tăng cường có thể dẫn đến những kết quả bất ngờ và tinh vi.”

Học tăng cường là một kỹ thuật học máy rất phổ biến, và neuroevolution, một phần của mô hình học tăng cường, thậm chí đã được sử dụng để dạy các mô hình cách chơi game như Super Mario, dưới dạng MarI/O của SethBling. Đây không phải là một khái niệm mới, nhưng là một khái niệm đã bị bỏ qua phần nào khi nói đến các LLM. Rất nhiều LLM sử dụng RLHF (Reinforcement Learning by Human Feedback), nhưng RL thuần túy không yêu cầu bất kỳ sự giám sát hoặc phản hồi nào của con người.

Chi Phí Đào Tạo “Bất Khả Thi” và Nỗi Lo Của Thị Trường Chứng Khoán

Hiểu lầm về chi phí 5.576 triệu USD

Tuyên bố này bắt nguồn từ whitepaper của DeepSeek V3, trong đó nói rằng mô hình này tốn 5.576 triệu USD để đào tạo, tiêu tốn 2788K giờ GPU Nvidia H800 với ước tính 2 USD mỗi giờ. Đây là chi phí của một mô hình, không phải tất cả các lần chạy thử nghiệm khác, không phải tất cả các lần họ xây dựng mô hình rồi phải xây dựng lại. Đây là chi phí đầu ra cuối cùng để xây dựng mô hình, không hơn không kém, và chắc chắn đã có sự đầu tư đáng kể hơn nhiều vào dự án này.

Sự bỏ sót này đã dẫn đến những cáo buộc rằng DeepSeek nói dối về chi phí của mình, mặc dù whitepaper đã nói rất rõ rằng chi phí đào tạo chỉ dành cho mô hình, không bao gồm bất kỳ chi phí phát sinh nào khác như nghiên cứu và phát triển, các mô hình được đào tạo trong quá trình xây dựng V3, và các chi phí liên quan khác. Điều này cũng không phải là chi phí của R1, mà là chi phí xây dựng V3. Eryck Banatt có một phân tích xuất sắc về chi phí này, khẳng định rằng các con số của DeepSeek là hợp lý và nhiều khía cạnh trong tuyên bố của họ có thể kiểm chứng được ngay từ đầu.

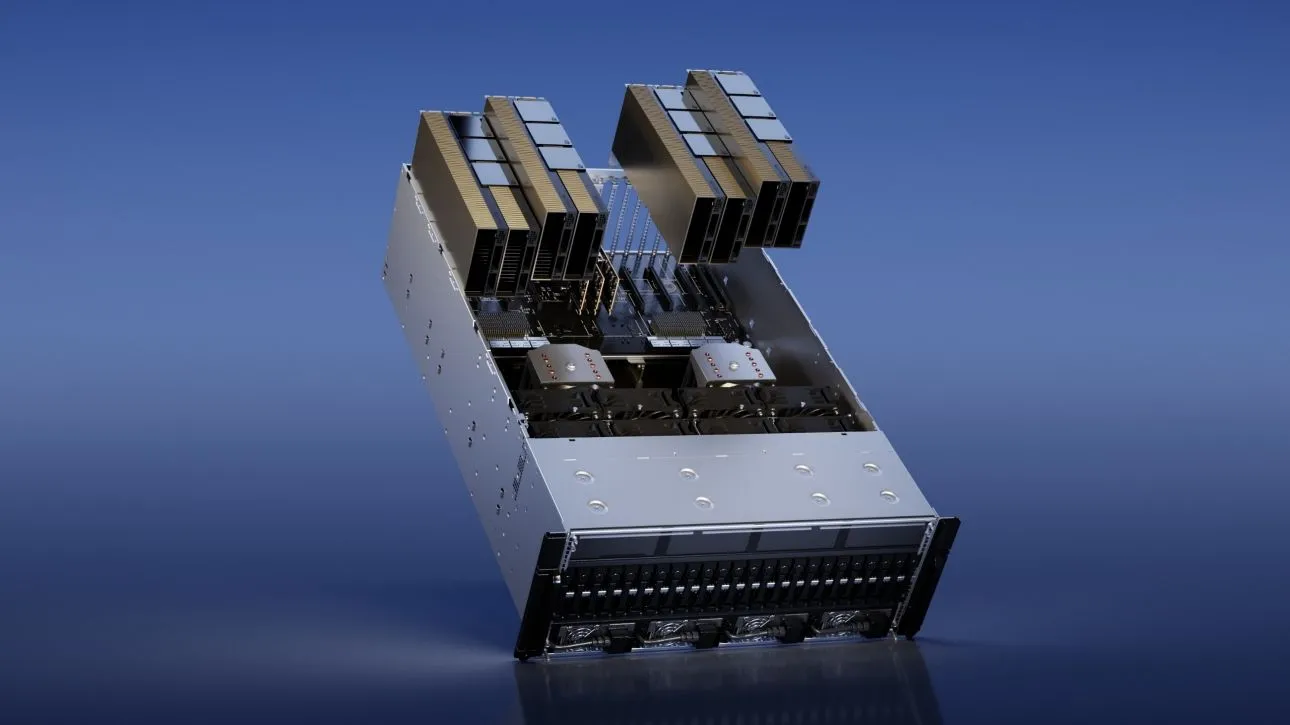

Tác động đến Nvidia và thị trường GPU

Tuy nhiên, những hiểu lầm cơ bản này (kết hợp với hiệu quả thực sự của các mô hình DeepSeek mới nhất) và việc đào tạo trên các GPU cũ hơn đã gây ra sự hỗn loạn trên thị trường. Các GPU Nvidia H100, được các ông lớn trong ngành AI như Google, Meta và OpenAI mua với số lượng hàng trăm nghìn chiếc, là những GPU mạnh nhất hiện có và trước đây được coi là cần thiết trong việc phát triển công nghệ tiên tiến.

GPU Nvidia H100

GPU Nvidia H100

Với những gì đã nói, DeepSeek đã đạt được tất cả những điều này trên một loạt GPU H800, loại GPU giảm tốc độ truyền chip-to-chip khoảng một nửa và tuân thủ các quy định xuất khẩu trong một thời gian ngắn trước khi một lỗ hổng mà Nvidia được cho là đã khai thác bị đóng lại. Điều này đặt ra câu hỏi về mức độ quan trọng thực sự của công nghệ mới nhất của Nvidia khi nói đến AI, nếu các GPU chậm hơn vẫn có thể cạnh tranh với kết quả của việc sử dụng những sản phẩm tốt nhất.

Những cáo buộc về H100 và phản hồi

Và còn một điều nữa; các cáo buộc nổi lên rằng DeepSeek đã lách luật kiểm soát xuất khẩu và mua lại GPU H100. CEO Scale AI Alexandr Wang đã tuyên bố rằng DeepSeek có khoảng 50.000 chiếc trong số đó và đã tránh nói về chúng vì điều đó sẽ chứng minh họ đã vi phạm các quy định kiểm soát xuất khẩu đó. Rất có thể Wang đã hiểu lầm một tweet từ Dylan Patel, trong đó nói rằng DeepSeek có hơn 50.000 GPU Hopper. GPU H800 vẫn là GPU Hopper, vì chúng là phiên bản sửa đổi của H100 được tạo ra để tuân thủ các quy định kiểm soát xuất khẩu của Hoa Kỳ.

Tất cả những điều này đã thúc đẩy Nvidia đưa ra một tuyên bố, nói rằng họ mong đợi tất cả các đối tác tuân thủ các quy định và sẽ hành động tương ứng nếu phát hiện họ không tuân thủ. Nvidia cũng “đã tuyên bố rằng không có lý do gì để tin rằng DeepSeek đã có được bất kỳ sản phẩm nào bị kiểm soát xuất khẩu từ Singapore,” theo Bộ Thương mại và Công nghiệp Singapore.

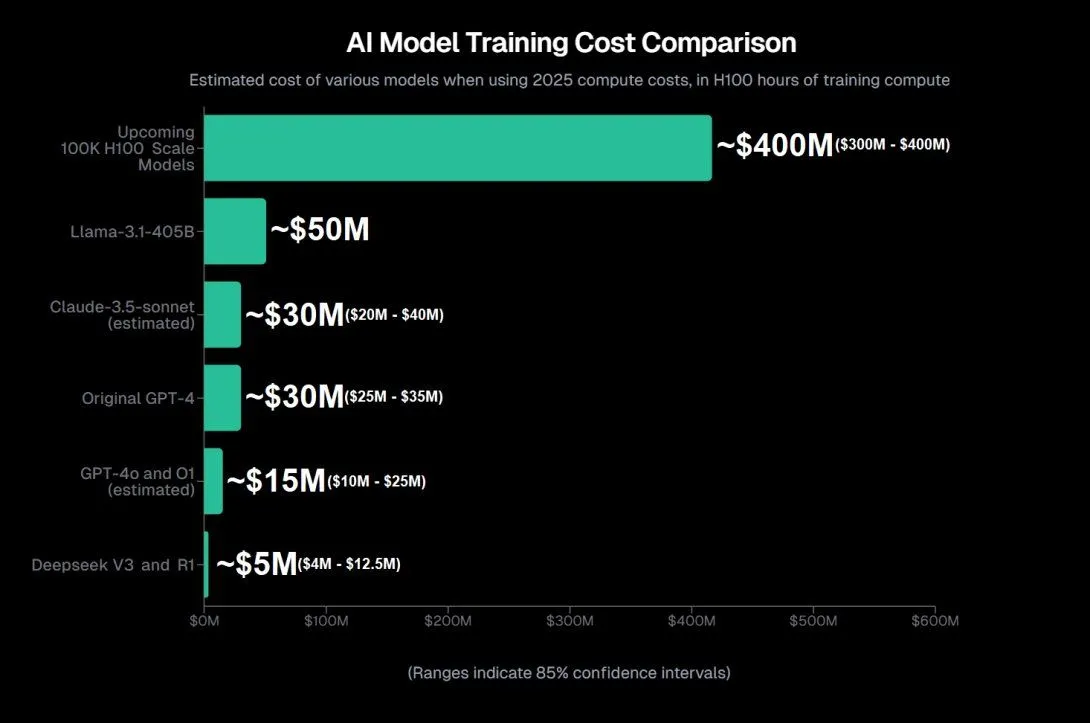

Biểu đồ chi phí đào tạo AI của Aran Komatsuzaki

Biểu đồ chi phí đào tạo AI của Aran Komatsuzaki

Ngay cả như vậy, chi phí này vẫn cực kỳ thấp. Aran Komatsuzaki, một nhà nghiên cứu AI, ước tính rằng chi phí đào tạo GPT-4o và GPT-o1 là khoảng 15 triệu USD mỗi mô hình, gấp ba lần chi phí của mô hình V3 của DeepSeek. Điều này một phần là nhờ tối ưu hóa, vì DeepSeek đã đạt được một số tiến bộ trong lĩnh vực này. Điều đó bao gồm việc sử dụng PTX, một ngôn ngữ cấp thấp dành cho GPU Nvidia cho phép các nhà nghiên cứu làm những việc như sử dụng một số GPU H800 để quản lý giao tiếp chéo chip.

DeepSeek: Bước Tiến Lớn Hướng Tới Một Tương Lai AI Dân Chủ Hóa

Lợi ích cho cộng đồng AI toàn cầu

Bất chấp những suy đoán rằng Meta đã thiết lập “phòng chiến tranh” và OpenAI có khả năng thực hiện hành động chống lại DeepSeek, đây là một chiến thắng lớn cho cộng đồng AI. Tiến bộ giúp ích cho tất cả mọi người, và tính chất “mở” trong nghiên cứu của DeepSeek sẽ cho phép các đối thủ cạnh tranh sử dụng một số kỹ thuật đó để cải thiện mô hình của riêng họ. Trở lại khi tôi đề cập rằng DeepSeek là “open weights”, lý do nó là “open weights” chứ không phải “open source” là vì mã nguồn mở cũng sẽ yêu cầu dữ liệu gốc mà nó được đào tạo.

Ngược lại, “open weights” có nghĩa là chúng ta có các tham số và các giá trị số xác định cách mô hình hoạt động. Điều đó, cùng với các tài liệu nghiên cứu, là quá đủ để bắt đầu khi cố gắng xây dựng một mô hình nhân bản R1. Trên thực tế, ai đó đã và đang làm việc để xây dựng phiên bản R1 của riêng họ trong một dự án có tên “Open R1”, sử dụng tất cả thông tin DeepSeek đã công bố để triển khai nó. Dự án này chưa hoàn thành, nhưng có một lộ trình và phác thảo rất rõ ràng để làm theo nếu bạn muốn tự mình thực hiện.

Ví dụ về khả năng suy luận của DeepSeek R1

Ví dụ về khả năng suy luận của DeepSeek R1

Nếu một người bình thường như bạn hoặc tôi có thể đọc bài báo và hiểu những điều cơ bản đang diễn ra, thì bạn biết rằng các nhà nghiên cứu tại các công ty như Google, Meta và OpenAI chắc chắn có thể. Điều này sẽ cải thiện các mô hình trên toàn diện, giảm tiêu thụ điện năng, chi phí và dân chủ hóa AI hơn nữa. CEO OpenAI Sam Altman đã nói rằng các mô hình suy luận của OpenAI giờ đây sẽ chia sẻ nhiều chuỗi suy nghĩ hơn, cảm ơn R1 trong phản hồi của ông.

Trải nghiệm sử dụng cá nhân

Bạn có thể chạy phiên bản DeepSeek R1 đã được chưng cất trong LM Studio ngay bây giờ, và tôi đã chạy mô hình Qwen 32B được chưng cất từ DeepSeek R1 trên MacBook Pro của mình với SoC M4 Pro bằng cách sử dụng LM Studio. Điều này cho thấy khả năng tiếp cận và ứng dụng của công nghệ DeepSeek không chỉ giới hạn ở các trung tâm dữ liệu lớn mà còn có thể được trải nghiệm ngay trên thiết bị cá nhân.

DeepSeek R1 không chỉ là một mô hình AI mạnh mẽ mà còn là một làn sóng đổi mới, thách thức những gã khổng lồ hiện có và định hình lại cục diện phát triển AI. Những tiến bộ về hiệu suất, tối ưu hóa chi phí và tính chất “open weights” của nó đang mở ra cánh cửa cho một tương lai AI dân chủ hơn, nơi mọi nhà phát triển và người dùng đều có thể hưởng lợi từ những đột phá công nghệ. Congnghetonghop.com tin rằng sự cạnh tranh này sẽ thúc đẩy toàn bộ ngành AI tiến lên, mang lại những giải pháp thông minh và hiệu quả hơn cho cuộc sống.

Bạn nghĩ sao về tác động của DeepSeek R1 đến thị trường AI và các công ty công nghệ lớn? Hãy chia sẻ ý kiến của bạn trong phần bình luận bên dưới hoặc tìm hiểu thêm các bài viết công nghệ chuyên sâu khác tại congnghetonghop.com!