Proxmox LXC (Linux Containers) từ lâu đã trở thành lựa chọn phổ biến trong cộng đồng ảo hóa nhờ bản chất nhẹ, tiêu tốn ít tài nguyên và khả năng khởi động nhanh chóng. Tuy nhiên, trong quá trình xây dựng và quản lý nhiều thiết lập Home Lab khác nhau, tôi nhận thấy mình có xu hướng chuyển sang sử dụng Máy ảo (VM) và các container Docker. Mặc dù LXC chắc chắn có vị trí riêng, bài viết này sẽ khám phá những lý do hàng đầu giải thích tại sao VM và Docker, thường được kết hợp, mang lại trải nghiệm vượt trội hơn cho những nhu cầu cụ thể của tôi.

1. VM mang lại khả năng cô lập và bảo mật tối ưu

Tránh các rủi ro bảo mật tiềm ẩn

Đây là điểm khác biệt quan trọng nhất. Khi nói đến cô lập, tôi muốn đề cập đến việc tách biệt một môi trường điện toán khỏi môi trường khác, và chủ yếu là khỏi chính hệ thống máy chủ vật lý (host). Mỗi VM chạy một hệ điều hành hoàn toàn độc lập, với kernel, không gian bộ nhớ và phần cứng ảo hóa riêng.

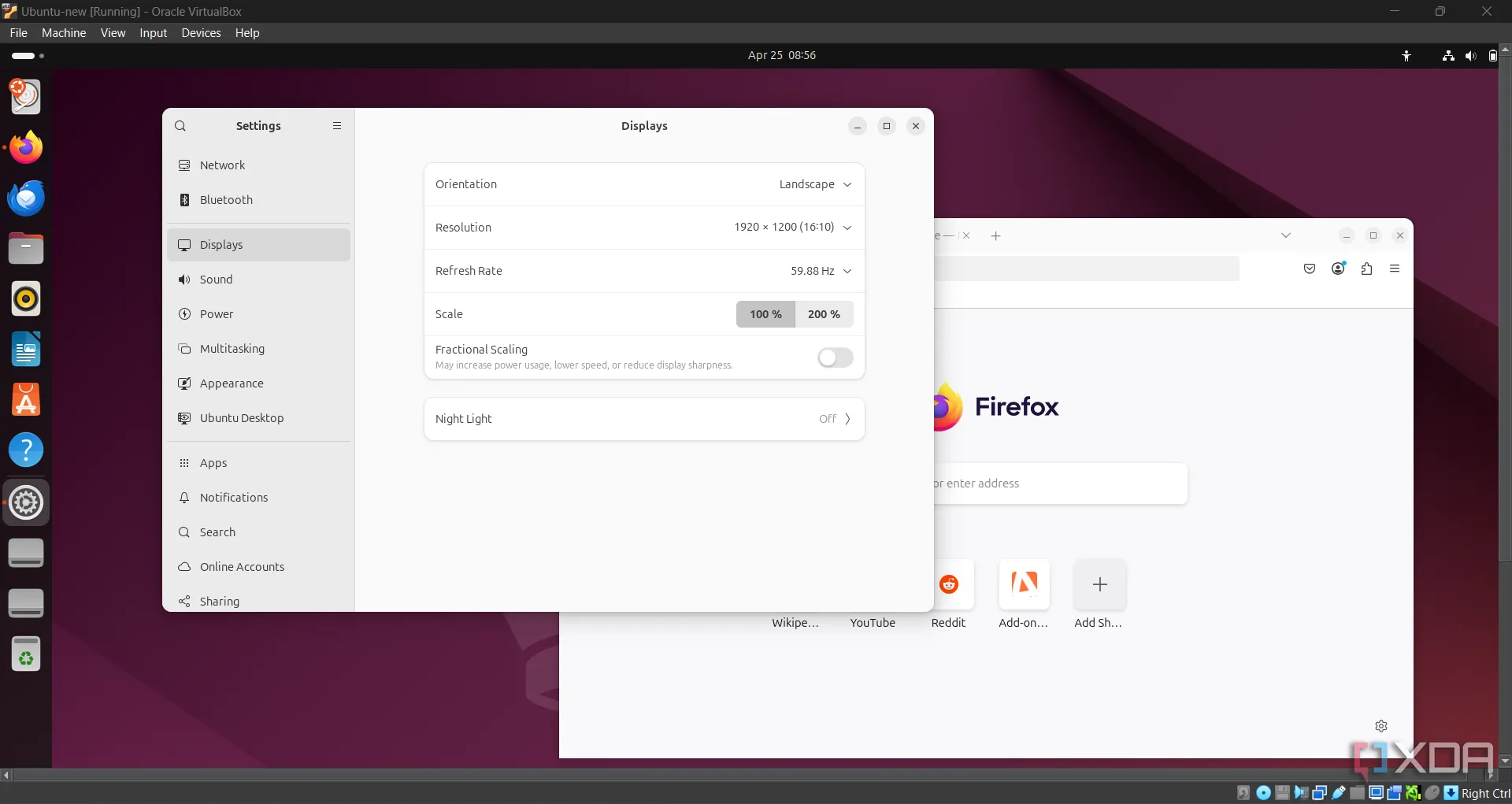

Môi trường ảo hóa Ubuntu chạy trên VirtualBox VM, minh họa khả năng cô lập của máy ảo trong Proxmox.

Môi trường ảo hóa Ubuntu chạy trên VirtualBox VM, minh họa khả năng cô lập của máy ảo trong Proxmox.

Nếu một VM cụ thể bị xâm nhập do lỗi bảo mật, kẻ tấn công sẽ khó có thể tác động đến hệ thống máy chủ hoặc các VM khác. Nó không thể truy cập trực tiếp vào kernel, hệ thống tệp tin của host, hoặc các VM khác mà không tìm thấy lỗ hổng trong chính hypervisor.

Ngược lại, các container LXC chia sẻ kernel với hệ thống host. Đây là sự khác biệt cơ bản. Mặc dù nó cung cấp khả năng cô lập quy trình rất tốt, nhưng tất cả các ứng dụng đều dựa vào cùng một kernel Linux của host Proxmox. Điều này có nghĩa là, nếu kẻ tấn công tìm thấy lỗ hổng cấp kernel trong một LXC, chúng có thể giành quyền truy cập vào hệ thống host và tất cả các LXC khác đang chạy trên host đó. Bất cứ khi nào tôi cần thiết lập một phần mềm mã nguồn mở mới với một codebase mới, tôi sẽ cài đặt ứng dụng web thử nghiệm trên một VM. Nếu ứng dụng đó có lỗ hổng dẫn đến việc bị xâm nhập toàn bộ hệ thống, phần mềm độc hại sẽ bị mắc kẹt trong môi trường cô lập của VM. Tôi có thể đơn giản xóa VM bị xâm nhập và bắt đầu lại từ đầu một cách an toàn.

2. Passthrough phần cứng chuyên dụng, hiệu suất vượt trội

Tận hưởng hiệu năng gốc

Đây là lúc các VM thực sự tỏa sáng. Tính năng passthrough phần cứng là một khả năng mà LXC không thể sánh được. Với VM, tôi có thể thực hiện PCI passthrough. Điều này cho phép một máy ảo kiểm soát trực tiếp một thiết bị phần cứng vật lý. VM tương tác với thiết bị như thể nó được cắm trực tiếp vào bo mạch chủ của chính nó. Cách tiếp cận này mang lại hiệu suất gần như gốc. Ví dụ, với GPU passthrough, tất cả các khả năng của một GPU được dành riêng cho VM đó.

Hệ thống dual GPU với card RTX 3080 Ti và GTX 1080, minh họa khả năng passthrough card đồ họa mạnh mẽ cho VM.

Hệ thống dual GPU với card RTX 3080 Ti và GTX 1080, minh họa khả năng passthrough card đồ họa mạnh mẽ cho VM.

Ngược lại, LXC hoạt động trên mô hình tài nguyên chia sẻ. Ở đây, LXC vẫn truy cập thiết bị thông qua kernel và driver của host. Nếu nhiều LXC cố gắng sử dụng cùng một thiết bị, điều này thường dẫn đến các vấn đề về hiệu suất và thiết lập phức tạp.

Giả sử bạn đã tạo một VM chuyên dụng (một VM Ubuntu Server) cho một máy chủ Jellyfin. Bạn có thể thực hiện PCI passthrough iGPU của Intel hoặc một GPU NVIDIA chuyên dụng trực tiếp cho VM này. Lúc này, khi dịch vụ cần chuyển mã video 4K sang Full HD cho điện thoại của tôi, nó sẽ sử dụng trực tiếp GPU được gán cho VM. Điều này mang lại hiệu suất chất lượng cao mà không ảnh hưởng đến các dịch vụ khác, bởi vì GPU hoàn toàn được dành riêng cho VM.

Về mặt kỹ thuật, tôi có thể cấp quyền sử dụng iGPU tích hợp cho LXC, nhưng sẽ có sự suy giảm hiệu suất và các vấn đề về độ ổn định. Bởi vì iGPU được sử dụng đồng thời bởi cả host Proxmox và Jellyfin khi bạn chạy Jellyfin trong một container LXC.

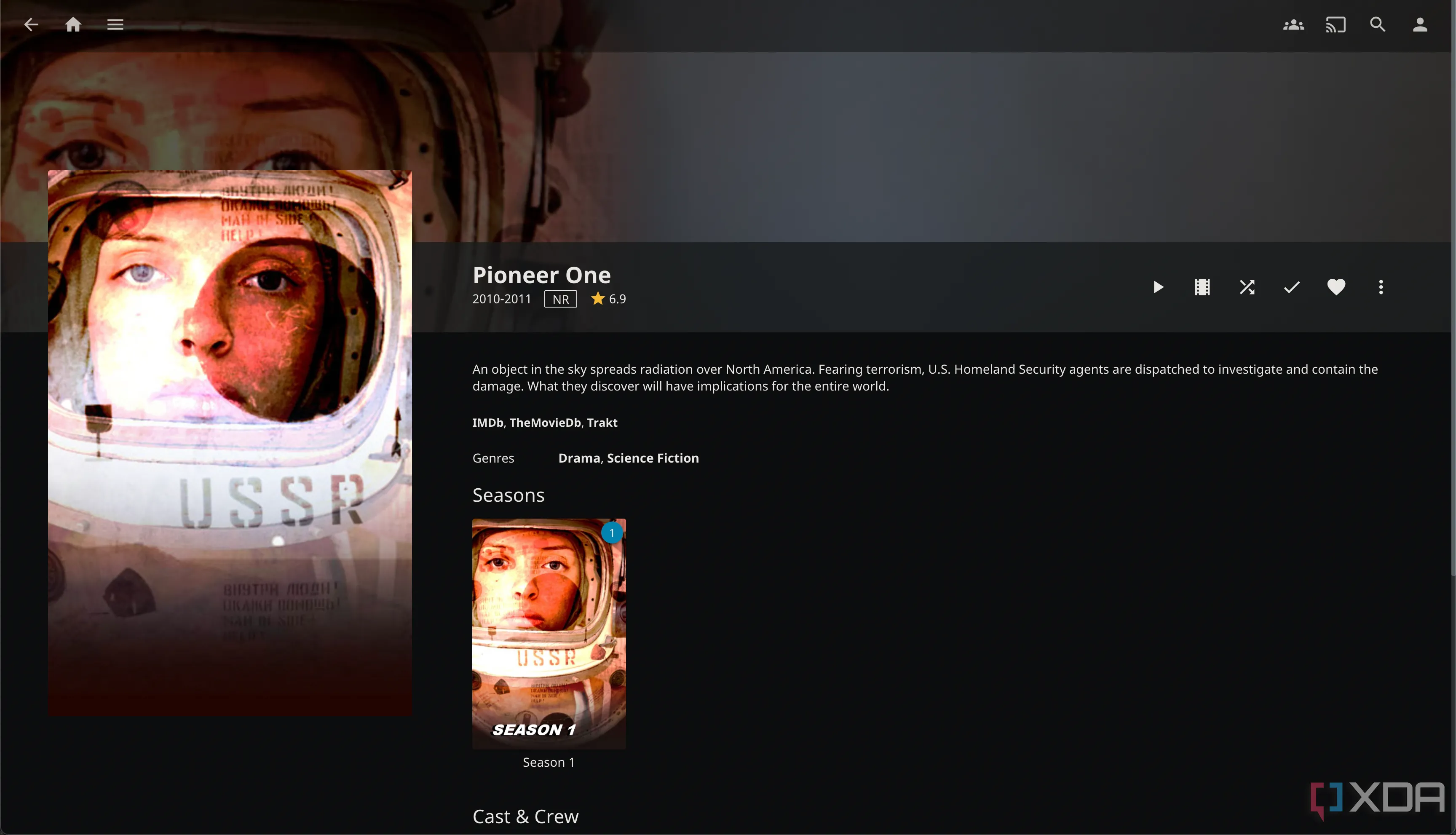

Giao diện một chương trình TV trên Jellyfin, minh họa ứng dụng của máy chủ media sau khi passthrough GPU cho VM.

Giao diện một chương trình TV trên Jellyfin, minh họa ứng dụng của máy chủ media sau khi passthrough GPU cho VM.

3. Docker xuất sắc cho ảo hóa cấp ứng dụng, tăng cường bảo mật khi kết hợp VM

Trong khi máy ảo ảo hóa toàn bộ máy, Docker tập trung vào việc đóng gói các ứng dụng riêng lẻ thành các đơn vị cô lập và di động gọi là container. Mặc dù các Docker container này cung cấp khả năng cô lập, chúng vẫn chia sẻ kernel cơ bản của host. Đây là lý do tôi chạy Docker bên trong một VM và thêm một lớp bảo mật bổ sung.

Nếu, bằng cách nào đó, một kẻ tấn công tinh vi cố gắng thoát khỏi một trong các Docker container của tôi, chúng sẽ vẫn bị giữ trong VM. Chúng sẽ không có quyền truy cập trực tiếp vào kernel, hệ thống tệp tin hoặc các VM khác của host.

Một lợi thế khác là các Docker container trong VM đó có thể dễ dàng tận dụng thiết bị đã được passthrough. Điều này tạo ra một đường dẫn rõ ràng cho việc tăng tốc phần cứng mà không cần cố gắng cấp quyền sử dụng phần cứng phức tạp trực tiếp cho các LXC. VM nhận phần cứng, và Docker bên trong VM đó có thể sử dụng nó một cách dễ dàng.

Chiến lược của người dùng chuyên nghiệp

Đối với tôi, những lợi ích rõ ràng của VM, chẳng hạn như khả năng phân tách phần cứng hoàn chỉnh, phân bổ tài nguyên chuyên dụng và khả năng passthrough các thiết bị quan trọng như GPU, khiến chúng trở thành lựa chọn hoàn hảo cho các khối lượng công việc đòi hỏi cao và các ứng dụng nhạy cảm. Đồng thời, Docker vượt trội trong việc đóng gói và khả năng di động ở cấp độ ứng dụng.

Điều này không có nghĩa là LXC đã lỗi thời. Chúng vẫn rất hữu ích trong các kịch bản cụ thể khi bạn cần một giải pháp nhẹ và việc chia sẻ kernel không phải là một hạn chế. Hãy chia sẻ ý kiến của bạn về cách bạn quản lý hệ thống ảo hóa của mình!